Bir otonom (sürücüsüz) aracın (OA) freninin bozulduğunu ve kontrolden çıktığını düşünün. OA, bu duruma nasıl bir yanıt verecek şekilde programlanmalıdır? Aracın içindeki yolcuya zarar verecek şekilde bir bariyere mi çarpmalıdır yoksa bir ya da birden fazla yayanın karşıdan karşıya geçtiği bir yaya geçidine mi yönelmelidir?

Ahlak Makinesi, 2016 yılında Exeter Üniversitesi Ekonomi Bölümünde ve Veri Bilimi ve Yapay Zeka Enstitüsünde Dr. Öğretim Üyesi olarak görev yapan Awad* ve ekibinin oluşturduğu çevrim içi bir platformdur. Bu web sitesi (Ahlak Makinesi), insanların, bir OA’nın kaçınılmaz zararı (kaza nedeniyle ölüm), araçtakiler ve yoldaki iki yaya seçeneği arasında nasıl dağıtması gerektiğine yönelik vereceği kararlardan hangisini onayladıklarına ilişkin bilgi toplamak ve bu onaylarının altında yatan faktörlerin neler olduğunu anlamak için tasarlanmış. Bunun için de karar vermesi zor, ikilemli senaryolar kullanılmış. Senaryolarda kullanılan ikilemler, ilk kez 1967’de filozof Phillipa Foot tarafından ortaya atılan ve “Tramvay problemi” olarak bilinen ünlü bir düşünce deneyinden esinlenilerek oluşturulmuş.

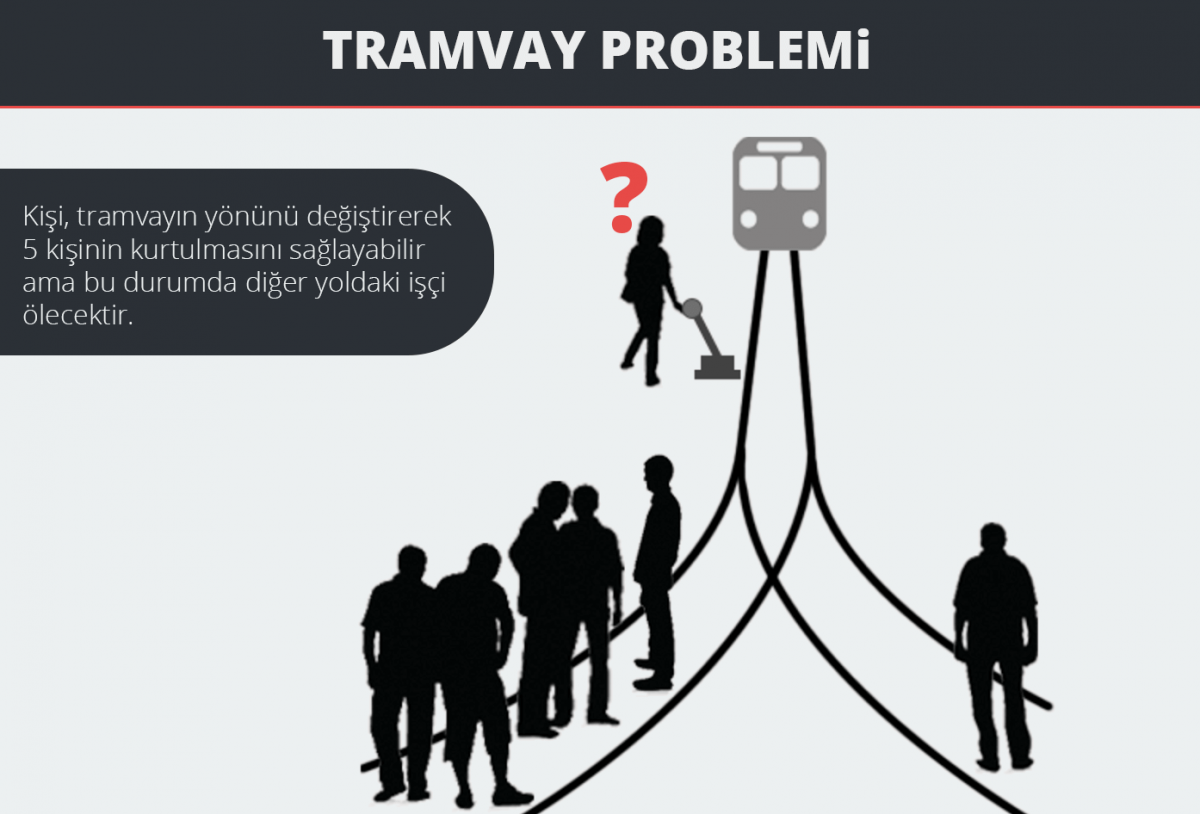

Tramvay probleminin bir versiyonu şu şekildedir: Kontrolden çıkmış bir tramvay, rayların üzerinde duran 5 kişiye çarpmak üzeredir. O anda tramvay, tramvayın makası değiştirilerek 1 kişinin olduğu yan raya saptırılabilir; ancak bunu yapmaya karar verdiğinizde 5 kişiyi, daha önce ölüm tehdidi altında olmayan 1 kişiyi öldürerek kurtarmış olacaksınız. Eğer müdahale etmezseniz, bu kez de eylemsizliğiniz nedeniyle 5 kişi ölmüş olacak. Tramvay yan yola yönlendirilmeli mi yoksa hiç müdahale etmeden 5 kişi ölüme mi bırakılmalı? Tren zaten -hayatın olağan akışında- 5 kişiye çarpacağı için benim bir şey yapmamam nötr bir etkidir, diye düşünüp eylemsizliğinizi meşrulaştırabilirsiniz. Diğer yandan bu duruma nicelik açısından bakıp, 5 kişi yerine 1 kişinin ölmesini yeğleyerek “5 kişiyi ölümden kurtarmış oldum.” da diyebilirsiniz. Tramvay probleminin dramatik bir anlatımına buradan ulaşılabilir.

Bu düşünce deneyi, felsefe, psikoloji ve sinirbilim başta olmak üzere “ahlaki karar verme” üzerine çalışan birçok bilim insanı tarafından değişimlenerek yaygın bir şekilde kullanılıyor. Tramvay probleminin, raylardaki insan sayısı, kurbanların özellikleri, izleyenlerin niyeti ve olayların nedensel sıralaması gibi farklı unsurları değiştirilip, katılımcılardan o durum hakkında yargıda bulunmaları istenerek ahlaki karar vermeyi etkileyen faktörler inceleniyor. Tramvay probleminin farklı bağlamlarda kullanılan örnekleri de mevcut. Ayrıca Kara Şövalye (The Dark Knight) filmindeki Joker’in sosyal deneyi -kurgu da olsa-, oldukça aykırı bir “grup ahlaki karar verme” deneyi örneğidir.

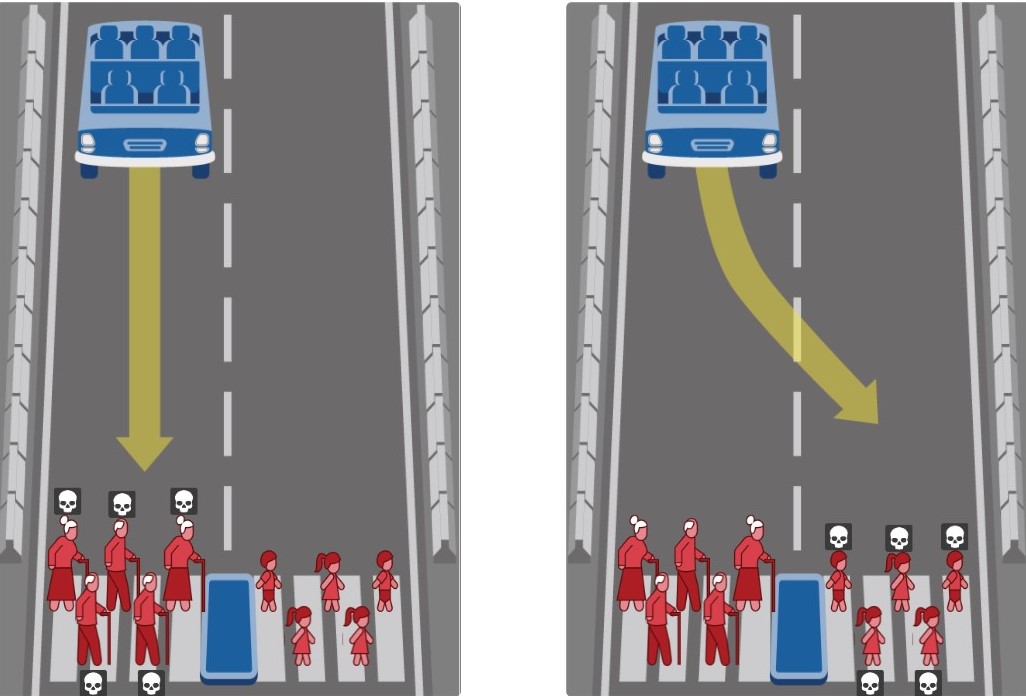

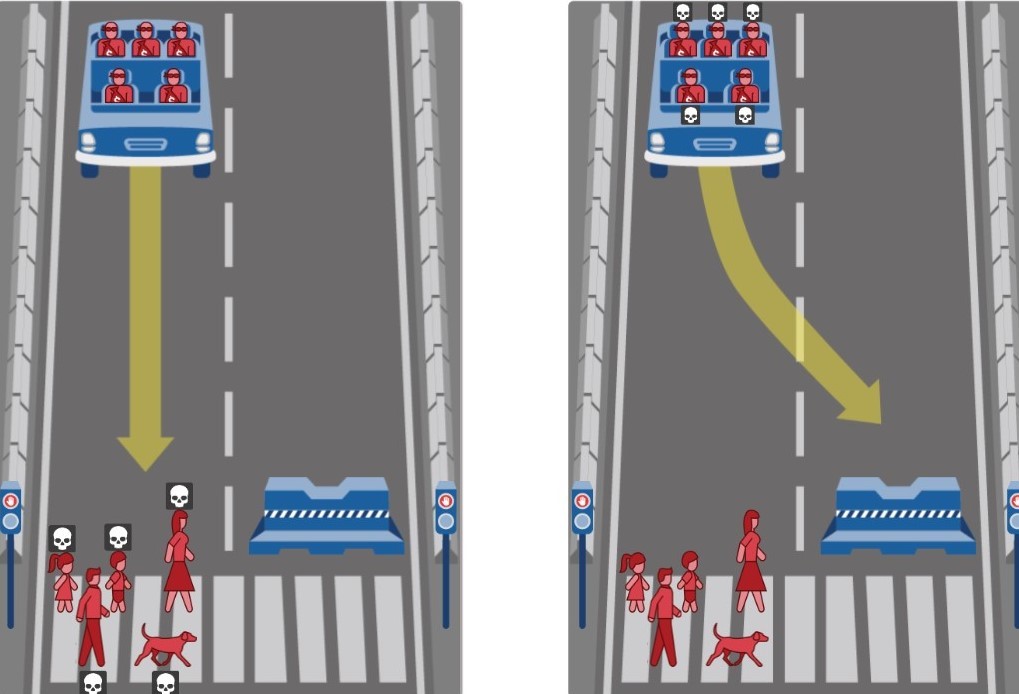

Awad ve ekibi, tramvay problemindeki bu mantığı, Ahlak Makinesine uyarlayarak OA’lar bağlamında yeniden düzenlemişler ve OA’yı karar verici olarak belirlemişler. Sonrasında bunu, insanların, yaşam ve ölüm durumlarını içeren zor ahlaki ikilemler karşısında verecekleri kararları anlamak amacıyla freni bozulan bir OA’nın, bariyere mi yoksa yayalara mı yahut yoldaki iki yaya grubundan hangisine çarpmasını onayladıklarını sormak için kullanmışlar. Katılımcılar, bu web sitesine giriş yaptıktan sonra, her biri kaçınılmaz zararın (kaza nedeniyle ölme) iki olası sonucunu içeren bir dizi senaryo görüp senaryolardaki sonuçlardan hangisini onaylıyorlarsa onu seçmişler.

Kaynak: https://www.moralmachine.net/

Senaryolar oluşturulurken, araştırmacılarca önceden belirlenen dokuz farklı unsur (faktör) değiştirilerek ahlaki ikilemler geliştirilmiş: müdahale (kalma ya da yoldan çıkma), OA ile ilişki (yayalar ya da yolcular), yasallık (kurallara uygun ya da kural dışı davranışlar), cinsiyet (kadın ya da erkek), yaş (genç ya da yaşlı), sosyal statü (yüksek ya da düşük), beden formu (atletik ya da geniş / şişman), kişi sayısı (daha fazla ya da daha az) ve canlı türü (insanlar ya da evcil hayvanlar). Ayrıca senaryolarda kullanmak üzere, doktorlardan bebek arabasındaki bebeklere ve suçlulardan evcil hayvanlara kadar 20 farklı karakter oluşturulmuş.

Kaynak: https://www.moralmachine.net/

Neticede tüm faktör ve karakterlerin birlikte kullanılmasıyla milyonlarca ikilem ortaya çıkmış. Ahlak Makinesiyle bugüne kadar 233 ülke ve bölgeden milyonlarca katılımcının, kaçınılmaz risk durumlarında verdikleri yaklaşık kırk milyon kararı kaydedilerek, şimdiye kadar toplanan en büyük YZ etiği veri havuzu oluşturulmuş. Herhangi bir kişisel bilgi kaydedilmemiş. Katılımcıların konum bilgileri ise IP adreslerinden belirlenmiş.

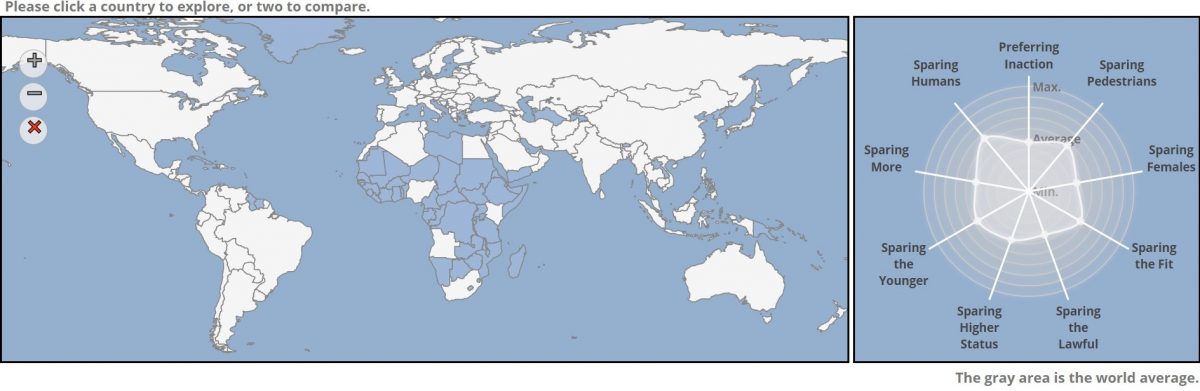

Ahlak Makinesinin verileri analiz edildiğinde sonuçlar, katılımcıların çoğunlukla hayvanlardan ziyade insanları ve yaşlılardan ziyade gençleri korumayı seçtiklerini göstermiş. İlginç kültürler arası farklılıklar da ortaya çıkmış. Verilen yanıtların, ülkelerin coğrafi konumlarına göre Batı, Doğu ve Güney olmak üzere üç ana kümede toplandığı (farklılaştığı) bulunmuş. Bununla birlikte kümeler arasındaki farklılıkların yalnızca ülkelerin coğrafi konumlarıyla değil, sahip oldukları modern kurumlarla ya da derin kültürel özelliklerle de açıklanabildiği gözlenmiş. Örneğin, hukukun üstünlüğünün kabul görüp uygulandığı ülkelerdeki insanların, kural ihlalleri yapanlardansa kurallara uyanları korumaya daha istekli olduğu (kırmızı ışıkta geçenler değil de trafik ışığı izin verdiğinde geçenler korunuyor); diğer ülkelerde ise bu faktörün, kazadan kimin korunacağına yönelik verilen kararlarda çok az etkili olduğu tespit edilmiş. Analiz sonuçlarını buradan inceleyebilirsiniz. Dünya haritasındaki ülkelerin üzerine tıklayarak ülkelerin sonuçlarını görebilirsiniz.

Kaynak: http://moralmachineresults.scalablecoop.org/

Çalışmanın Türkiye sonuçlarına da erişmeniz mümkün ancak web sitesinin Türkçe dil seçeneği bulunmuyor. Bu nedenle, çalışmaya katılanlardan alınan yanıtlara ilişkin sonuçların tüm ülkeye genellenip genellenemeyeceği tartışılır. Web sitesinin sunduğu dilleri bilenlerin yanı sıra çeviri motoru kullanılarak da katılım sağlanmış olabilir ama yine de İnternet’e erişim, konuya ilgi duyma veya bu çalışmadan haberdar olma gibi etkenler de hesaba katıldığında bu ihtimal düşük denebilir. Aynı durum diğer ülkeler için de söz konusu ve zaten bakıldığında çalışmanın amacı, ülkelere göre ahlaki karar farklarını ya da bir ülkenin vatandaşlarının ahlaki ikilemlerde neye göre hangi kararı verdiğini incelemek değil. Eğer öyle olsaydı, her ülkenin örnekleminin tüm ülkeyi temsil etmesi için daha incelikli bir araştırma tasarlarlardı. Araştırmacılar verilerle oynamayı sever. Elbette, ellerinde katılımcıların IP adresleri de varken, verileri ülkelere göre de kategorize edip analiz edeceklerdi ve araştırmanın bu yöndeki sınırlılığını da makalelerinde belirteceklerdi. Bunda bir yanlışlık yok, aksine diğer araştırmacılara orada daha ayrıntılı bir çalışma yapmaya değecek bir “şey” olduğunu göstermesi açısından anlamlıdır. Bu çalışmayla, kimin öleceğine karar verilmesi gereken ikilemli durumlarda, insanların karar vermelerinde etkili olacağını düşündükleri faktörleri belirleyip, özelliklerini bu faktörler açısından değiştirerek oluşturdukları senaryoları görenlerin, neye karar vereceklerini tespit etmeyi amaçlamışlar. Asıl amaçları, YZ etiği alanına katkıda bulunup bu bilgileri, bir gün bizim yerimize karar verecek olan YZ’ye aktarmak. Bu çalışmayla, bu süreçte referans alabilecekleri önemli bir kaynağa daha ulaşmış görünüyorlar. Çalışmalarının sonuçlarını incelediklerinde önemli bir şey daha fark etmişler. Çalışmanın sonuçları, 2016 yılında OA etik kurallarının oluşturulması için kurulan komisyonun (etik, teknoloji ve hukuk alanındaki uzmanlardan oluşan) verileri ile karşılaştırıldığında, sonuçlarla uzmanların görüşleri arasında örtüşen noktaların yanı sıra temel görüş farklılıklarının olduğunu görmüşler. Örneğin, hem Ahlak Makinesine katılanlar hem de uzmanlar, hayvanların hayatını değil insanların hayatını kurtarmayı tercih etmişler. Diğer yandan katılımcılar, yaşlılar yerine çocukları kurtarmayı onaylarken uzmanlar, yaşa dayalı ayrımcılığı reddetmişler.

Peki, bu bilgilerle ne yapacağız?

Awad ve ekibi, Ahlak Makinesi gibi web siteleri tasarlayıp bunları, toplumsal kararların alınması sürecinde kural ve yasaları oluşturanların görüşlerine katkı sağlayabilecek veri kaynakları oluşturmak için kullanabileceğimizi belirtiyor.

“Yapay zekanın etik ilkeleri neler olmalı?” sorusuna cevap bulma arayışında kullanılan kitle kaynak oluşturma yöntemi, toplumsal bir kararın alınması sürecine dahil edilebilir mi? Ahlak Makinesi gibi çevrim içi platformlar, toplumu ilgilendiren durumlarla ilgili kural ve yasaların oluşturulması aşamasında, uzmanların ve milletvekillerinin görüşlerinin yanı sıra vatandaşların görüşlerini de hesaba katmak için bir yol olabilir mi? Bu soruların cevabı “evet” ise bunu, hangi durumlar için ve nasıl yapacağız? Bunu yapabilmemiz için hangi ön koşulların sağlanması gereklidir? vb. sorular sorarak işe başlayabiliriz.

Aslında İnternet’e erişimin kolaylaşması ve sosyal medya kullanımının yaygınlaşmasıyla birlikte, özellikle Twitter kullanıcılarının, diğer her şeyin yanı sıra yanlış uygulamalar ve davranışlar veya yasaların büsbütün uygulanmayışı karşısında da fikirlerini söyleyerek işleyişe ya da işlemeyişe etki edebildiklerini görüyoruz. Bu, kurallar koyulurken ve yasalar oluşturulurken neden olmasın?

Örneğin, bazı kişileri kısa sürede öldürürken bazılarını pek de etkilemeyebilen; ancak kimi öldürüp kimi etkilemeyeceği önceden tahmin edilemeyen bir virüsün ortaya çıktığını hayal edin. Kısa bir süre sonra da bu durumun pandemi olduğu ilan edilsin. Virüsün, insandan insana temas ve solunum yoluyla bulaştığı anlaşılınca da insanların virüsten korunmaları için gerekli kısıtlamalar getirilmeye başlansın. Bunlar: Maske takmak, kişisel temizlik kurallarına uymak, belirli günlerde evde karantinada kalmak, mümkün olduğunca ev dışında kapalı alanlarda bulunmamak gibi kısıtlamalar olsun. Bir yandan da insanların cezaevi gibi kapalı alanlarda kalabalık halde yaşadığı yerlerdeki insan sayısının azaltılması planlansın. Çocuk cinsel istismarı, insan öldürme ve tecavüz suçlarını işleyenlerin, yaşama, bedenin bütünlüğü ve bireysel özel alan sınırlarının korunması hakkını ihlal ettikleri için, üst düzey karar mekanizmaları (adli bilim kurulu, milletvekilleri ve ülke başkanı) tarafından seçenek dışı bırakıldığını hayal edelim.

Bu aşamada, üst düzey karar vericilerin, kimlerin cezaevinden çıkabileceğine yönelik bir taslak hazırladıklarını; ancak -nihayetinde cezası bitmeden cezaevinden çıkan kişiler toplumun içine karışacağından- bu durumun, toplumun tüm bireylerini ilgilendirdiğini düşünerek vatandaşların fikirlerini bilmek istediklerini hayal edelim. Bunun için de uzman bilim insanları tarafından vatandaşların, hangi mahkumun salıverilmesine onay vereceğini tespit edeceğimiz bir “Af Makinesi” tasarlanmış olsun. Mahkumların; uyuşturucu, kaçakçılık, dolandırıcılık, düşünme, hırsızlık gibi ceza alma nedenleri, senaryodaki karakterler olarak belirlenmiş olsun. İnsanların bu konuda karar vermesini etkileyeceği düşünülen faktörler de: Cinsiyet (kadın x erkek) yaş (18 yaş altı x 18-65 yaş x 65 yaş üstü) ceza süresi (1-5 sene x 5-10 sene x 10-15 sene x 15-20 sene x 20 sene üzeri) geriye kalan ceza süresi (1-3 sene x 4-6 sene x 7-9 sene x 10-12 sene) olsun. Bu 4 kategorideki alt özelliklerden birer tanesi her seferinde tek bir karakterde toplanarak bunlardan ikili senaryolar oluşturulsun. Örneğin, bir senaryodaki karakterlerinden biri, tarihi eser kaçakçılığı nedeniyle 20 sene ceza alan ve cezasının bitmesine 5 sene kalan 36 yaşında bir erkek; diğeri ise insan kaçakçılığı nedeniyle 20 sene ceza alan ve cezasının bitmesine 15 sene kalan 66 yaşında bir erkek olsun ve her ikisi de ellerinde bir valizle bir kapıdan çıkarken görünsün. Hangi mahkumun cezaevinden çıkmasına onay verirsiniz?

Devamında, Awad ve Levine’in, Ahlak Makinesi benzeri web sitelerinin toplumsal karar alma süreçlerinde kullanılmasını nedenleriyle birlikte önerdikleri Behavioral Scientist’teki makalelerinin -ilgili kısımlarının- çevirisini okuyabilirsiniz.

Yapay Zeka Etiğini Neden Kitle Kaynaklı Yapmalıyız? (ve Bunu Sorumlu Olarak Nasıl Yaparız?)

“Yapay zeka (YZ) giderek daha güçlü hale gelirken YZ’nin aynı zamanda daha az insan denetimi gerektirmeye başladığını inkar etmek imkansızdır. Güçlü YZ’ler yalnızca rutin görevleri bağımsız olarak yerine getirmekle kalmıyor; artık kendi başlarına zor etik kararlar da alıyor.

Örneğin; otonom araçlar, bir sorun ile karşılaştığında kaçınılmaz riskin dağılımını yoldaki herkese (sürücüler, yolcular, yayalar, bisikletliler) dengelemeli ve ne yapacağına buna göre karar vermelidir. Sağlık hizmetlerinde kullanılan algoritmalar; personelden daha fazla ilgi görme, ventilatör gibi özel ekipman veya nakil için gerekli olan bir organ gibi sınırlı sayıdaki tıbbi kaynakları hangi hastaların alacağına karar vermelidir. Adalet sistemindeki algoritmalar da kimin kefaletle serbest bırakılacağını belirlemek zorundadır. Öyle ama “adil” bir kararı ne oluşturur?

Şu anda, bu sorunun net veya üzerinde genel bir fikir birliğine varılmış bir cevabı bulunmuyor. Sınırlı sayıda olan bir ekipmanı kimin alacağını belirleyen bir sağlık hizmeti algoritması düşünün. Bazı insanlar, algoritmaların tüm insanlara eşit davranması ve tahsisin ilk hizmet esasına göre yapılması gerektiğine inanarak ekipmanın ilk gelene verilmesini öneriyor. Diğerleri ise tahsisin, yaşam beklentisine veya iyileşme şansına dayalı olması gerektiğine inanıyor. Ayrıca toplumda önemli bir rol oynayacağı düşünülen hastalara (örneğin, organ nakli yapan bir doktor) öncelik verilmesi gerektiğini savunuyor. Amerika Birleşik Devletleri gibi çeşitlilik içeren toplumlar bir yana; bunun gibi ahlaki anlaşmazlıklar oldukça homojen topluluklarda bile olabiliyor.

Bu kararları hangi ahlaki ilkeler yönetmelidir? Bu kararları kim verecek?

Bazıları bunları yasa koyuculara (policymakers) ve hukuk ve uygulamalı ahlakbilim gibi alanlardaki gibi uzmanlara bırakmamız gerektiğini savunuyor; ancak bu durumda önemli bir sorunun cevaplanması gerekiyor: Halkın çıkarları ve tercihleri bazı durumlarda (hepsinde değilse de) hesaba katılmalı mıdır? Öyleyse halkın çıkarları ve tercihleri nasıl hesaba katılmalıdır? İlk etapta, halkın tercihlerinin ne olduğunu nasıl öğrenebiliriz?

Biz, etik ikilemler hakkında kitlesel olarak kullanan büyük ölçekli çevrim içi çalışmaların, halkın tercihleri hakkında içgörü kazanmak için siyasi süreçte kullanılan kamuoyu yoklamaları gibi yöntemlere katkıda bulunabileceğine inanıyoruz.

Kitle kaynaklı etik terimi, “Popüler olan her zaman doğrudur.” ifadesini destekler göründüğünden ilk başta bu tartışılır gelebilir. Aksine, bu makaledeki amacımız kitle kaynak kullanımının, politikacıların kendi seçmenlerinin görüşleri hakkında sahip oldukları bilgileri artırmanın yeni ve önemli bir yolu olduğunu önermektir. Kitle kaynaklı etiğin oynaması gerektiğini düşündüğümüz rol mütevazı ancak değerlidir ve tüm iyi yasa oluşturma araçları gibi sorumlu gözetim ile birleştirilmelidir.

Etik tercihler için kitle kaynak kullanımı

…

Artık bu bilgiye sahip olduğumuza göre, bu bilgiyle ne yapmalıyız? Halkın görüşlerini nasıl ölçeriz?

Bazıları Ahlak Makinesinin verilerini gereksiz, hatta tehlikeli olarak görebilir. Sonuçta, birçok insan, kendilerinden farklı insanlara karşı örtük veya aleni olabilen önyargılara ya da düşünce yanlılıklarına sahiptir. Yapay zeka sistemlerinin ahlaki karar verme sürecini belirlemede dayandırdığımız temelin; ırkçı, cinsiyetçi ve homofobik önyargıları ve diğer tahammülsüz tutumları içermesi hiç kuşkusuz büyük bir sorun yaratacaktır.

Dahası, etik kararların çoğu ancak o duruma ait karmaşık gerçekleri anlamak için yeterli zaman harcandıktan sonra alınabilir. Belirli bir sağlık hizmeti politikası ekonomiyi nasıl etkileyecek? Yeni bir yol inşa edilerek trafiğin düzeni nasıl değiştirilecek? Karma, demokratik bir toplumda, seçilmiş temsilciler tarafından atanan yasa koyucular ve bürokratlar, politik kararlar alma konusunda seçmenlerinden daha iyi bir konumdadırlar. Politik kararlarını etkileyen gerçekleri araştırmak ve mevcut seçeneklerin (ve de kendi seçimlerinin) sonuçlarını değerlendirmekle görevlidirler. Verdikleri kararlar (ideal bir dünyada) en adil kararlar olacaktır. Öyleyse neden konuyu anlamak için yeterli zamanı harcamamış kişilerin tavsiyelerini alsınlar? Bu tür kararları sadece uzmanlara bırakmamız, konuyu kendi başlarına çözmeleri en iyisi değil mi?

Ne yazık ki bu çözüm tam olarak tatmin edici değil. Uzmanların yeterli eğitime ve bilgeliğe sahip olduklarına ve halkın ilgisini yürekten anladıklarına inandığımızda bile geriye cevaplanması gereken şu soru kalıyor: Halkın çıkarının gerçekte ne olduğunu nasıl biliyorlar? Halkın görüşünün ön yargılı, daha az bilgiye dayalı ve son söz olmaması gerektiğini kabul etsek de bu, uzmanların halkın görüşünü basitçe reddedebilecekleri anlamına gelir mi? Eğer gelmiyorsa; uzmanların, insanların ilgisini öğrenebilmelerinin en iyi yolu nedir?

Yasa koyucular, kamunun fikirlerini ölçmek için halihazırda kamuoyu anketlerini kullanıyor. Bu yöntemler yararlı olsa da erişim, maliyet ve yöntem ile sınırlıdır.

Kamuoyu araştırması, halkın temsili bir örneğini (örneklemi) inceleyerek genel halkın görüşlerinin nispeten doğru bir tahminine ulaşılabileceği fikrine dayanır. Birçok anket, anlamlı derecede önyargılardan veya düşünme yanlılıklarından mustarip olan (örneğin, çağrıya cevap vermeye ve katılmaya istekli olanlarla sınırlı olan) telefon görüşmeleri ve yüz yüze görüşmeler kullanır. Bu nedenle aslında, halkı temsil etmeyen bir örneklemden veri toplanmış olur. Bu yöntemlerle ilgili bir başka sorun da, zaman ve emek açısından maliyetli olmaları nedeniyle ölçeklendirilmelerinin zor olmasıdır. Bazı kamuoyu anketleri son zamanlarda çevrim içi panellerin gücünden yararlanmaya başladı. Böylece önceki yöntemlere göre halkı daha iyi temsil eden örnekleme ulaşmayı garantilediklerini iddia ediyorlar (bu prosedürü ölçeklendirmenin maliyeti de hala bir engel olmaya devam ediyor). Dahası, kamuoyu araştırmaları, genellikle yanıt verenlerin yanıtlarının ardındaki nedenleri belirsizleştirir. Oysa kamuoyu anketinin temel amacı, kişilerin neden öyle hissettiklerini ortaya çıkarmadan halkın tutumunu tahmin etmektir.

…

Bu araçlar, yasa koyucuların halkın tercihlerini anlamasında boşluklar bırakmaktadır. Tercih toplama sürecini halk için daha erişilebilir hale nasıl getirebiliriz? Halkı katılmaya nasıl teşvik edebiliriz? Ve bu tutumlara katkıda bulunan faktörleri bilimsel titizlikle nasıl araştırabiliriz?

Ahlak Makinesi gibi çevrim içi kitle kaynaklı platformların bu boşlukları doldurmaya yardımcı olacak bir çözüm sunduğuna inanıyoruz. Bu tür platformlar genellikle oldukça erişilebilir ve kullanımı zevklidir, bu nedenle çok sayıda insana ulaşır. Ayrıca, verilerden daha titiz sonuçların çıkarılmasına olanak tanıyan rastgele kontrollü deneyler olarak da tasarlanabilirler.

Yeni ve ihtiyaç duyulan bir bakış açısı

İnternet’teki milyonlarca (ön yargılı, habersiz) kullanıcının varsayımsal senaryolara verdikleri yanıtlar, yapay zeka etiği çerçevesinde yeni yasalar oluşturma açısından nasıl yararlı olabilir?

Ahlak Makinesi aracılığıyla topladığımız veriler, kamuoyunun fikirlerinin uzmanlarınkiyle uyumlu olan ve olmayan yönlerini görmemiz için bir içgörü sağladı. 2016 yılında, otonom araçlar için ilk kez etik kuralları oluşturmak için etik, teknoloji ve hukuk alanındaki uzmanlardan oluşan bir Alman komisyonu kuruldu. Ahlak Makinesi aracılığıyla toplanan verileri komisyon raporu ile karşılaştırdığımızda, kamuoyunun ve uzmanların görüşleri arasında bir miktar örtüşme olsa da temel anlaşmazlıklar olduğunu gördük. Örneğin, her iki taraf da insan hayatını kurtarmak için hayvanları kurban etme konusunda hemfikir. Ancak, kamuoyu büyük ölçüde çocukları yaşlılar pahasına korumayı onaylarken, uzmanlar yaşa dayalı her türlü ayrımcılığı reddettiler.

Etik kararlar verirken uzmanların kararlarının halkın ihtiyaçlarını karşılaması gerekli olmamakla birlikte; uzmanlar, özellikle doğru kararın fark edilmesinin zor olduğu politik kararlar verirken halkın katılımının önemli olabileceği durumlarda, halkın görüşlerini bilmekle ilgilenebilirler.

Bir grup uzman bile, özellikle zor ahlaki sorularla karşı karşıya kaldıklarında bazen bir anlaşmaya varamayabilir. Örneğin; Alman Komisyonu, hem kişisel yaralanma sayısını azaltmak için kapsayıcı bir programlama yapılmasını, hem de mağdurlardan birinin özelliklerinin diğerine göre belirginleştirilmesinin engellenmesini önerdi. Bu, tek bir öneride aynı anda iki çelişkili görüşü (her ikisi de uzmanlar tarafından onaylanmıştır) birleştirme çabası olarak görünüyor. Bununla birlikte, her iki öneri de kendi başına uygulanabilir olsa da, her ikisini de öneren bir argümana nasıl yanıt verileceğini kestirmek zordur. Bu gibi durumlarda, politika uzmanları çelişkili kurallar koymak yerine vatandaşların tercihlerini bir eşitlik bozucu olarak kullanmayı deneyebilir. Hangi kuralların genel olarak kabul edilebilir olduğunu belirlemek için konuyu kamuoyu tartışmasına açmayı tercih edebilir. Diğer türlü, politika uzmanları, vatandaşların tercihlerini sorunlu bulup onları yok saymaya karar verdiklerinde, politikalarının yaratacağı tepkiye hazırlıklı olmalı ve seçtikleri bu kararları halka nasıl açıklayacaklarını dikkatlice düşünmelidirler.

Daha da ileriye gidersek bu türden kültürler arası veriler, evrensel bir makine etiği ilkeleri üzerine küresel bir fikir birliğine ulaşma olasılığımızı belirlememize yardımcı olabilir. Dahası bu veriler sayesinde, bir Doğu ülkesindeki yasa koyucular, kendi ülkelerinin vatandaşlarının tercihlerinin ve beklentilerinin Batı ülkelerindekilerden (ve tersi) nasıl farklılaştığını anlayabilirler. Sonuç olarak, Avrupa komisyonları tarafından hazırlanan bazı politik yönergeler, kabul edilmeden önce bu veriler ışığında yeniden gözden geçirilebilir. Bunun için ülkelerin, vatandaşlarının belirli durumlardaki ahlaki yargılarını anlamak adına kendi yerel yönetimlerinin bizim geliştirdiğimiz Ahlak Makinesini ve bulgularımızı bir başlangıç noktası olarak kullanarak kendi araçlarını tasarlaması ve çalıştırması gerekecektir. Yerel popülasyonlar hakkında giderek daha incelikli veriler toplandıkça, OA’lar ile ilgili etik kuralları bir ülkeden diğerine aktarmanın mantıklı olup olmayacağı sorusunu yanıtlamaya başlayabiliriz.

Sınırlılıklar konusunda net olmak

Ahlak Makinesi gibi platformların sınırlılıkları konusunda net olmak önemlidir.

İlk olarak, daha önce de belirttiğimiz gibi, Ahlak Makinesi kullanıcılarından toplanan tercihlerin doğrudan yasaya dönüştürülmesi veya işin OA’lara kodlanmak üzere mühendislere devredilmesi gerektiğine inanmıyoruz. Bunun yerine; bu platformda veya diğerlerinde toplanan yargıların, niteliksel olarak bir yasa koyucuyu veya yasa önerileri yapan bir grup uzmana fikir vereceğini düşünüyoruz.

İkincisi, bu platformlar genel popülasyonun temsili örneklerini garanti etmez. Bu alıştırmanın katılımcıları, web sitemizi ziyaret etmeyi seçen kişilerdir (İnternet erişimi olanlar ve sürücüsüz araç teknolojisine meraklı olanlar). Bu göz önüne alındığında, yasa koyucular mevcut verileri halkın tercihine ilişkin son söz olarak kabul etmemelidir.

Son olarak, gerçek dünya senaryoları çok boyutlu ve karmaşıktır. Verilerimiz, bu vakaların birkaç ilginç veya önemli yönünü yakalayan basitleştirilmiş senaryolardan türetilmiştir. Ahlak Makinesini tasarlarken, OA’ların ahlaki karar verme süreciyle ilgili her faktörü ortaya koymadık. Eylemlerin sonuçları hakkında da belirsizlik getirmedik (çarpma sonucu yaralanma, sakat kalma ya da hiçbir şey olmama ihtimallerini işin içine katmadık). Bu sınırlılıklara rağmen, Ahlak Makinesi, OA etiğinin neler olabileceğine ilişkin önemli psikolojik fenomenleri ortaya çıkarmaya başladı. (OA etiğini araştırmak için basitleştirilmiş tramvay problemi benzeri senaryoları kullanan çalışmalarla ilgili argümanlar için buraya, buraya ve buraya bakın.) Bununla birlikte, basit varsayımsal tramvay senaryolarının diğer son derece önemli olan etik sorulardan uzaklaşmaması gerektiği gerçeğini de vurgulamak istiyoruz. Özellikle OA’ların, yolda karşılaşılan riski nasıl dağıttığı sorusundan.

YZ, giderek hayatımıza girip önemli etik kararlar almaya başlıyor. Bu nedenle, YZ teknolojilerinin geliştirilmesi ve düzenlenmesi, yasa koyucular ile halk arasında bir diyaloğun geliştirilmesini gerektiriyor. Bu amaçla, halkın görüşlerini öğrenmek için yeni teknikler ve araçlar geliştirilmelidir. Bu makalede, böyle bir teknik geliştirme deneyimimizi özetledik. Çabalarımızın, YZ düzenleme sürecinin nasıl demokratikleştirileceği konusunda daha fazla yaratıcı düşünceye ilham vereceğini umuyoruz.”

*Edmond Awad, Exeter Üniversitesi Ekonomi Bölümünde ve Veri Bilimi ve Yapay Zeka Enstitüsünde Dr. Öğretim Üyesi olarak görev yapıyor. Aynı zamanda Max Planck İnsani Gelişme Enstitüsünde araştırmacı ve Yapay Zeka ve Etik dergisinin kurucu yayın kurulu üyesidir. Yapay zeka, etik, hesapsal sosyal bilimler ve multi-agent sistemler üzerine çalışmalar yürüten Awad, Exeter Üniversitesine katılmadan önce MIT Medya laboratuvarında doktora sonrası çalışmasını yaptı. 2016 yılında, sürücüsüz arabaların karşılaştığı ahlaki ikilemlerle ilgili insan kararlarını toplayan bir web sitesi olan Ahlak Makinesinin (Moral Machine) tasarımına ve geliştirilmesine yönelik çalışmalarını yönetti. 70 milyon ikilemle ilgili karar senaryosu bulunan web sitesi 4 milyondan fazla kullanıcı tarafından ziyaret edildi. Ayrıca hayırseverliğe ilişkin 2 milyondan fazla ikilem senaryosu içeren MyGoodness adlı başka bir web sitesi de bulunuyor.

Kaynaklar:

- Awad, E., Dsouza, S., Kim, R., Schulz, J., Henrich, J., Shariff, A., … & Rahwan, I. (2018). The Moral Machine experiment. Nature, 563(7729), 59.

- Awad, E. (2019). Your (Future) Car’s Moral Compass. Behavioral Scientist.

- Awad, E., Levine, S. (2020). Why We Should Crowdsource AI Ethics (and How to Do So Responsibly). Behavioral Scientist.

***Değirmendere MezeEvi sakinlerine sevgiler***